Hoy en día, es demasiado fácil para los gobiernos vigilar permanentemente y restringir el derecho a la intimidad, la libertad de reunión, la libertad de movimiento y la libertad de prensa.

Los seres humanos y las máquinas están destinados a vivir en una relación cada vez más estrecha. Para que sea un matrimonio feliz, tenemos que abordar mejor las implicaciones éticas y legales que conlleva la ciencia de la información.

La inteligencia artificial, y en particular sus subcampos de aprendizaje automático y aprendizaje profundo, sólo pueden ser neutrales en apariencia, si es que lo son. Debajo de la superficie, puede llegar a ser extremadamente personal.

Los beneficios de basar las decisiones en cálculos matemáticos pueden ser enormes en muchos sectores de la vida. Sin embargo, confiar demasiado en la IA implica intrínsecamente determinar patrones más allá de estos cálculos y, por lo tanto, puede volverse contra los usuarios, perpetrar injusticias y restringir los derechos de las personas.

De hecho, la IA puede afectar negativamente a una amplia gama de nuestros derechos humanos. El problema se agrava por el hecho de que las decisiones se toman sobre la base de estos sistemas, mientras que no hay transparencia, responsabilidad ni salvaguardias sobre cómo se diseñan, cómo funcionan y cómo pueden cambiar con el tiempo.

Invadiendo el derecho a la intimidad y el derecho a la igualdad

La tensión entre las ventajas de la tecnología de AI y los riesgos para nuestros derechos humanos se hace más evidente en el campo de la privacidad. La privacidad es un derecho humano fundamental, esencial para vivir con dignidad y seguridad. Pero en el entorno digital, incluso cuando utilizamos aplicaciones y plataformas de medios sociales, se recopilan grandes cantidades de datos personales -con o sin nuestro conocimiento- y pueden utilizarse para perfilarnos y producir predicciones de nuestros comportamientos. Proporcionamos datos sobre nuestra salud, ideas políticas y vida familiar sin saber quién va a utilizar estos datos, con qué fines y por qué.

Las máquinas funcionan en base a lo que los humanos les dicen. Si un sistema se alimenta de sesgos humanos (conscientes o inconscientes), el resultado será inevitablemente sesgado. La falta de diversidad e inclusión en el diseño de los sistemas de IA es, por lo tanto, una preocupación clave: en lugar de hacer nuestras decisiones más objetivas, podrían reforzar la discriminación y los prejuicios al darles una apariencia de objetividad. Cada vez hay más pruebas de que las mujeres, las minorías étnicas, las personas con discapacidad y las personas LGBTI sufren en particular discriminación mediante algoritmos sesgados.

Los estudios han demostrado, por ejemplo, que Google tenía más probabilidades de mostrar anuncios de empleos altamente remunerados a los hombres que a las mujeres. El pasado mes de mayo, un estudio de la Agencia de los Derechos Fundamentales de la Unión Europea también puso de relieve cómo la IA puede ampliar la discriminación. Cuando la toma de decisiones basada en datos refleja prejuicios sociales, reproduce -e incluso refuerza- los sesgos de esa sociedad. Este problema también ha sido planteado a menudo por el mundo académico y las ONG, que recientemente adoptaron la Declaración de Toronto, en la que piden salvaguardias para evitar que los sistemas de aprendizaje automático contribuyan a las prácticas discriminatorias.

Las decisiones tomadas sin cuestionar los resultados de un algoritmo defectuoso pueden tener graves repercusiones para los seres humanos. Por ejemplo, el software utilizado para informar las decisiones sobre la asistencia sanitaria y las prestaciones por discapacidad ha excluido injustamente a las personas que tenían derecho a ellas, con graves consecuencias para las personas afectadas.

Asfixiar la libertad de expresión y la libertad de reunión

Otro derecho en juego es la libertad de expresión. En una reciente publicación del Consejo de Europa sobre algoritmos y derechos humanos se señalaba, por ejemplo, que Facebook y YouTube habían adoptado un mecanismo de filtrado para detectar contenidos extremistas violentos. Sin embargo, no se dispone de información sobre el proceso o los criterios adoptados para establecer qué vídeos muestran “contenidos claramente ilegales”.

Aunque no se puede dejar de aplaudir la iniciativa de detener la difusión de ese material, la falta de transparencia en torno a la moderación del contenido suscita preocupación porque puede utilizarse para restringir la libertad de expresión legítima e invadir la capacidad de las personas para expresarse.

Se han planteado preocupaciones similares en relación con el filtrado automático del contenido generado por los usuarios, en el momento de la carga, que supuestamente infringe los derechos de propiedad intelectual, que pasó a un primer plano con la propuesta de Directiva sobre derechos de autor de la UE. En determinadas circunstancias, el uso de tecnologías automatizadas para la difusión de contenidos también puede tener un impacto significativo en el derecho a la libertad de expresión y a la privacidad, cuando se utilizan bots, ejércitos de trolls, spam dirigido o anuncios, además de algoritmos que definen la visualización de contenidos.

La tensión entre tecnología y derechos humanos también se manifiesta en el campo del reconocimiento facial. Si bien esto puede ser una herramienta poderosa para que los funcionarios encargados de hacer cumplir la ley encuentren a presuntos terroristas, también puede convertirse en un arma para controlar a la gente. Hoy en día, es demasiado fácil para los gobiernos vigilarles permanentemente y restringir el derecho a la intimidad, la libertad de reunión, la libertad de movimiento y la libertad de prensa.

Qué deben hacer los gobiernos y el sector privado

La IA tiene el potencial de ayudar a los seres humanos a maximizar su tiempo, libertad y felicidad. Al mismo tiempo, puede llevarnos a una sociedad distópica. Por lo tanto, encontrar el equilibrio adecuado entre el desarrollo tecnológico y la protección de los derechos humanos es una cuestión urgente, de la que depende el futuro de la sociedad en la que queremos vivir.

Para hacerlo bien, necesitamos una cooperación más estrecha entre los agentes estatales -gobiernos, parlamentos, poder judicial, organismos encargados de hacer cumplir la ley-, las empresas privadas, el mundo académico, las ONG, las organizaciones internacionales y también el público en general. La tarea es desalentadora, pero no imposible.

Ya existe una serie de normas que deberían servir de punto de partida. Por ejemplo, la jurisprudencia del Tribunal Europeo de Derechos Humanos establece límites claros para el respeto de la vida privada, la libertad y la seguridad. También subraya la obligación de los Estados de proporcionar un recurso efectivo para hacer frente a las intrusiones en la vida privada y proteger a las personas de una vigilancia ilícita. Además, el Convenio modernizado del Consejo de Europa para la protección de las personas con respecto al tratamiento automatizado de datos de carácter personal, adoptado este año, aborda los retos que plantea para la intimidad el uso de las nuevas tecnologías de la información y la comunicación.

Los Estados también deben asegurarse de que el sector privado, que es responsable del diseño, la programación y la aplicación de la inteligencia artificial, respete las normas de derechos humanos. La recomendación del Consejo de Europa sobre las funciones y responsabilidades de los intermediarios de Internet, los principios rectores de las Naciones Unidas sobre las empresas y los derechos humanos, y el informe sobre la regulación del contenido del Relator Especial de las Naciones Unidas sobre la promoción y protección del derecho a la libertad de opinión y de expresión, deberían alimentar los esfuerzos por desarrollar una tecnología de inteligencia artificial capaz de mejorar nuestras vidas. Es necesario que haya más transparencia en los procesos de toma de decisiones mediante el uso de algoritmos, a fin de comprender el razonamiento que los sustenta, garantizar la rendición de cuentas y poder cuestionar estas decisiones de manera eficaz.

Un tercer campo de acción debería ser el aumento de la “alfabetización en IA” de las personas. Los Estados deberían invertir más en iniciativas de sensibilización y educación del público para desarrollar las competencias de todos los ciudadanos, y en particular de las generaciones más jóvenes, a fin de comprometerse positivamente con las tecnologías de la inteligencia artificial y comprender mejor sus implicaciones para nuestras vidas. Por último, las estructuras nacionales de derechos humanos deberían estar equipadas para hacer frente a los nuevos tipos de discriminación derivados del uso de la inteligencia artificial.

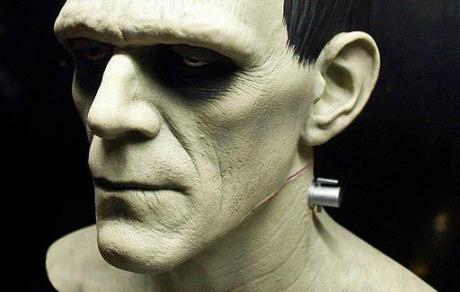

La inteligencia artificial puede mejorar enormemente nuestras habilidades para vivir la vida que deseamos. Pero también puede destruirlas. Por lo tanto, tenemos que adoptar normas estrictas para evitar que se transforme en un monstruo moderno de Frankenstein.

Hoy en día, es demasiado fácil para los gobiernos vigilar permanentemente y restringir el derecho a la intimidad, la libertad de reunión, la libertad de movimiento y la libertad de prensa.

Los seres humanos y las máquinas están destinados a vivir en una relación cada vez más estrecha. Para que sea un matrimonio feliz, tenemos que abordar mejor las implicaciones éticas y legales que conlleva la ciencia de la información.

La inteligencia artificial, y en particular sus subcampos de aprendizaje automático y aprendizaje profundo, sólo pueden ser neutrales en apariencia, si es que lo son. Debajo de la superficie, puede llegar a ser extremadamente personal.

Los beneficios de basar las decisiones en cálculos matemáticos pueden ser enormes en muchos sectores de la vida. Sin embargo, confiar demasiado en la IA implica intrínsecamente determinar patrones más allá de estos cálculos y, por lo tanto, puede volverse contra los usuarios, perpetrar injusticias y restringir los derechos de las personas.

De hecho, la IA puede afectar negativamente a una amplia gama de nuestros derechos humanos. El problema se agrava por el hecho de que las decisiones se toman sobre la base de estos sistemas, mientras que no hay transparencia, responsabilidad ni salvaguardias sobre cómo se diseñan, cómo funcionan y cómo pueden cambiar con el tiempo.

Invadiendo el derecho a la intimidad y el derecho a la igualdad

La tensión entre las ventajas de la tecnología de AI y los riesgos para nuestros derechos humanos se hace más evidente en el campo de la privacidad. La privacidad es un derecho humano fundamental, esencial para vivir con dignidad y seguridad. Pero en el entorno digital, incluso cuando utilizamos aplicaciones y plataformas de medios sociales, se recopilan grandes cantidades de datos personales -con o sin nuestro conocimiento- y pueden utilizarse para perfilarnos y producir predicciones de nuestros comportamientos. Proporcionamos datos sobre nuestra salud, ideas políticas y vida familiar sin saber quién va a utilizar estos datos, con qué fines y por qué.

Las máquinas funcionan en base a lo que los humanos les dicen. Si un sistema se alimenta de sesgos humanos (conscientes o inconscientes), el resultado será inevitablemente sesgado. La falta de diversidad e inclusión en el diseño de los sistemas de IA es, por lo tanto, una preocupación clave: en lugar de hacer nuestras decisiones más objetivas, podrían reforzar la discriminación y los prejuicios al darles una apariencia de objetividad. Cada vez hay más pruebas de que las mujeres, las minorías étnicas, las personas con discapacidad y las personas LGBTI sufren en particular discriminación mediante algoritmos sesgados.

Los estudios han demostrado, por ejemplo, que Google tenía más probabilidades de mostrar anuncios de empleos altamente remunerados a los hombres que a las mujeres. El pasado mes de mayo, un estudio de la Agencia de los Derechos Fundamentales de la Unión Europea también puso de relieve cómo la IA puede ampliar la discriminación. Cuando la toma de decisiones basada en datos refleja prejuicios sociales, reproduce -e incluso refuerza- los sesgos de esa sociedad. Este problema también ha sido planteado a menudo por el mundo académico y las ONG, que recientemente adoptaron la Declaración de Toronto, en la que piden salvaguardias para evitar que los sistemas de aprendizaje automático contribuyan a las prácticas discriminatorias.

Las decisiones tomadas sin cuestionar los resultados de un algoritmo defectuoso pueden tener graves repercusiones para los seres humanos. Por ejemplo, el software utilizado para informar las decisiones sobre la asistencia sanitaria y las prestaciones por discapacidad ha excluido injustamente a las personas que tenían derecho a ellas, con graves consecuencias para las personas afectadas.

Asfixiar la libertad de expresión y la libertad de reunión

Otro derecho en juego es la libertad de expresión. En una reciente publicación del Consejo de Europa sobre algoritmos y derechos humanos se señalaba, por ejemplo, que Facebook y YouTube habían adoptado un mecanismo de filtrado para detectar contenidos extremistas violentos. Sin embargo, no se dispone de información sobre el proceso o los criterios adoptados para establecer qué vídeos muestran “contenidos claramente ilegales”.

Aunque no se puede dejar de aplaudir la iniciativa de detener la difusión de ese material, la falta de transparencia en torno a la moderación del contenido suscita preocupación porque puede utilizarse para restringir la libertad de expresión legítima e invadir la capacidad de las personas para expresarse.

Se han planteado preocupaciones similares en relación con el filtrado automático del contenido generado por los usuarios, en el momento de la carga, que supuestamente infringe los derechos de propiedad intelectual, que pasó a un primer plano con la propuesta de Directiva sobre derechos de autor de la UE. En determinadas circunstancias, el uso de tecnologías automatizadas para la difusión de contenidos también puede tener un impacto significativo en el derecho a la libertad de expresión y a la privacidad, cuando se utilizan bots, ejércitos de trolls, spam dirigido o anuncios, además de algoritmos que definen la visualización de contenidos.

La tensión entre tecnología y derechos humanos también se manifiesta en el campo del reconocimiento facial. Si bien esto puede ser una herramienta poderosa para que los funcionarios encargados de hacer cumplir la ley encuentren a presuntos terroristas, también puede convertirse en un arma para controlar a la gente. Hoy en día, es demasiado fácil para los gobiernos vigilarles permanentemente y restringir el derecho a la intimidad, la libertad de reunión, la libertad de movimiento y la libertad de prensa.

Qué deben hacer los gobiernos y el sector privado

La IA tiene el potencial de ayudar a los seres humanos a maximizar su tiempo, libertad y felicidad. Al mismo tiempo, puede llevarnos a una sociedad distópica. Por lo tanto, encontrar el equilibrio adecuado entre el desarrollo tecnológico y la protección de los derechos humanos es una cuestión urgente, de la que depende el futuro de la sociedad en la que queremos vivir.

Para hacerlo bien, necesitamos una cooperación más estrecha entre los agentes estatales -gobiernos, parlamentos, poder judicial, organismos encargados de hacer cumplir la ley-, las empresas privadas, el mundo académico, las ONG, las organizaciones internacionales y también el público en general. La tarea es desalentadora, pero no imposible.

Ya existe una serie de normas que deberían servir de punto de partida. Por ejemplo, la jurisprudencia del Tribunal Europeo de Derechos Humanos establece límites claros para el respeto de la vida privada, la libertad y la seguridad. También subraya la obligación de los Estados de proporcionar un recurso efectivo para hacer frente a las intrusiones en la vida privada y proteger a las personas de una vigilancia ilícita. Además, el Convenio modernizado del Consejo de Europa para la protección de las personas con respecto al tratamiento automatizado de datos de carácter personal, adoptado este año, aborda los retos que plantea para la intimidad el uso de las nuevas tecnologías de la información y la comunicación.

Los Estados también deben asegurarse de que el sector privado, que es responsable del diseño, la programación y la aplicación de la inteligencia artificial, respete las normas de derechos humanos. La recomendación del Consejo de Europa sobre las funciones y responsabilidades de los intermediarios de Internet, los principios rectores de las Naciones Unidas sobre las empresas y los derechos humanos, y el informe sobre la regulación del contenido del Relator Especial de las Naciones Unidas sobre la promoción y protección del derecho a la libertad de opinión y de expresión, deberían alimentar los esfuerzos por desarrollar una tecnología de inteligencia artificial capaz de mejorar nuestras vidas. Es necesario que haya más transparencia en los procesos de toma de decisiones mediante el uso de algoritmos, a fin de comprender el razonamiento que los sustenta, garantizar la rendición de cuentas y poder cuestionar estas decisiones de manera eficaz.

Un tercer campo de acción debería ser el aumento de la “alfabetización en IA” de las personas. Los Estados deberían invertir más en iniciativas de sensibilización y educación del público para desarrollar las competencias de todos los ciudadanos, y en particular de las generaciones más jóvenes, a fin de comprometerse positivamente con las tecnologías de la inteligencia artificial y comprender mejor sus implicaciones para nuestras vidas. Por último, las estructuras nacionales de derechos humanos deberían estar equipadas para hacer frente a los nuevos tipos de discriminación derivados del uso de la inteligencia artificial.

La inteligencia artificial puede mejorar enormemente nuestras habilidades para vivir la vida que deseamos. Pero también puede destruirlas. Por lo tanto, tenemos que adoptar normas estrictas para evitar que se transforme en un monstruo moderno de Frankenstein.

Fuente

Compartir esto: