Este proyecto del Servel responde a la irrupción de las nuevas tecnologías y, particularmente, el uso de redes sociales por las que se propagan estas noticias falsas con una velocidad asombrosa y cómo esto tuvo una importante injerencia en los procesos eleccionarios de Estados Unidos, el referéndum por el Brexit en el Reino Unido y recientemente en la primera vuelta de las elecciones presidenciales de Brasil.

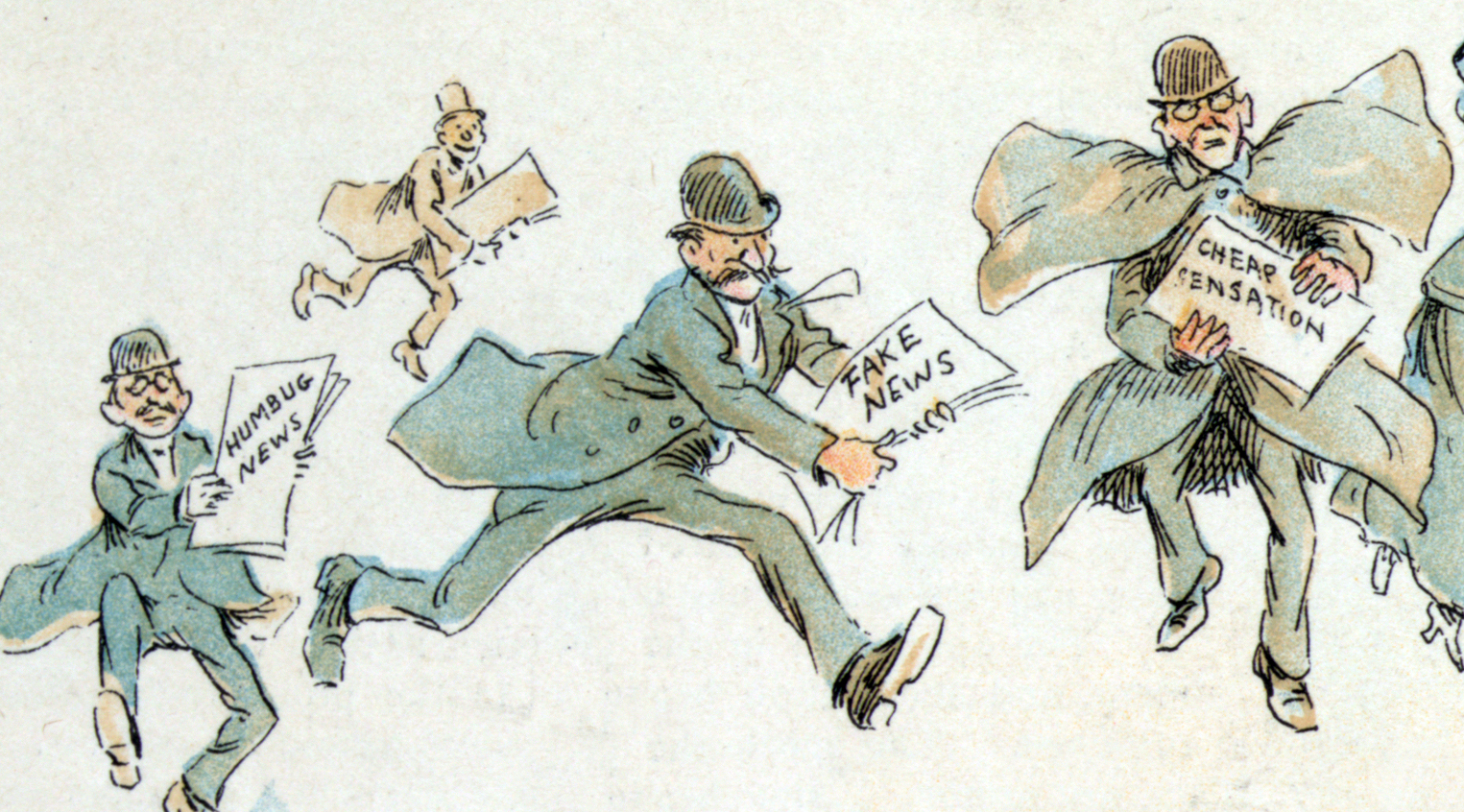

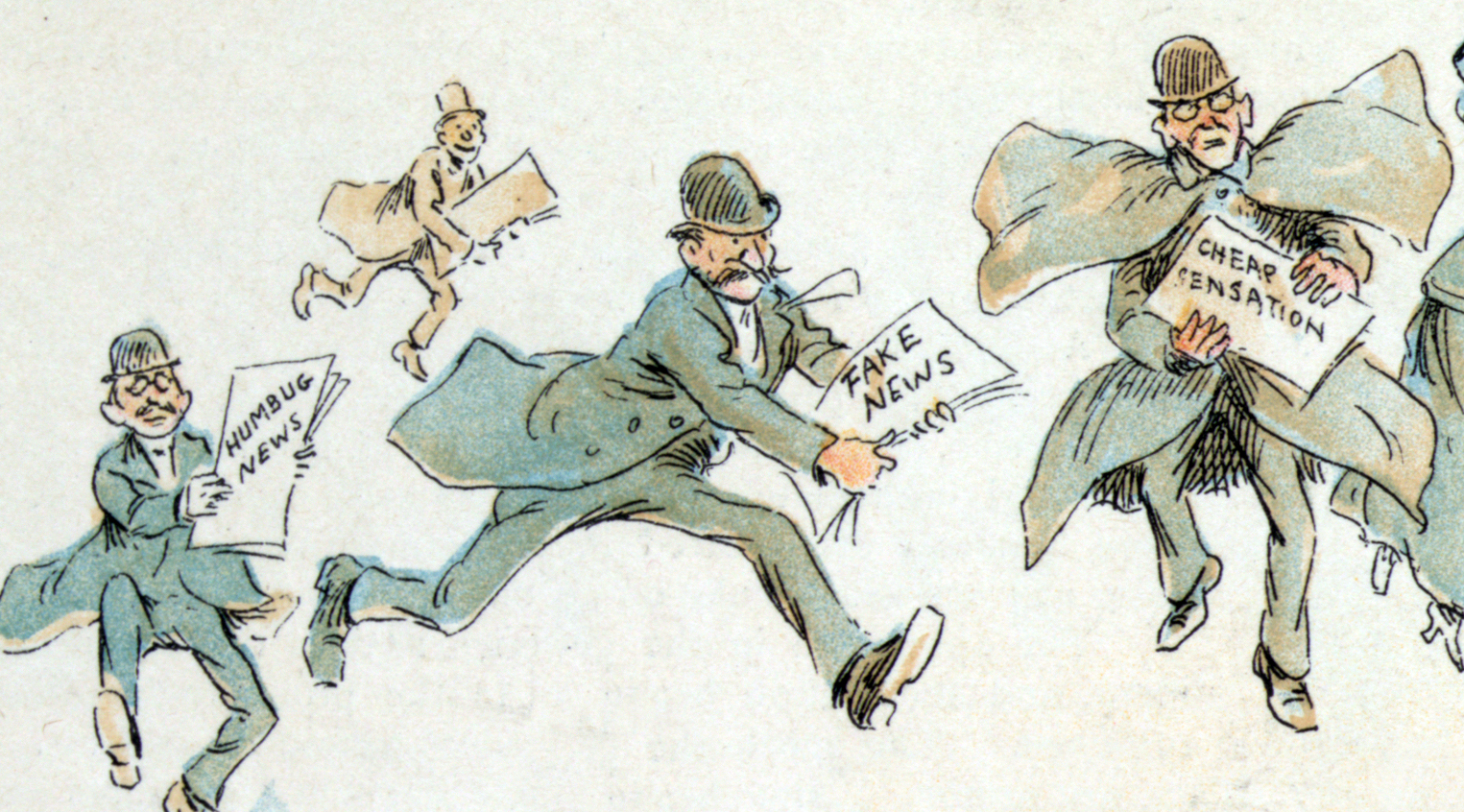

El concepto “fake news” apareció en Chile a la par con el de postverdad en 2016. Ambos neologismos tienen en común su procedencia: las elecciones en Estados Unidos en las que ese país decidió a Donald Trump como presidente, lo que sigue siendo hasta hoy motivo de análisis.

Durante la pasada elección presidencial chilena, se implementó la plataforma Chilecheck cuyo objetivo era la comprobación de las declaraciones de los candidatos. Mauricio Duce, director de Espacio Público y uno de los expertos que trabaja en la plataforma digital de verificación de discurso público, nos explica el método que ellos utilizaron para llevar adelante esta comprobación.

“Lo que es chequeable son las afirmaciones de hecho y no opiniones, ya que éstas no son ni verdaderas ni falsas. Las afirmaciones, sin embargo, pueden ser contrastadas con evidencias. El método supone que tienes que pulir aquella frase que puede ser o no verificable y para eso hay criterios de selección. Se eligen aquellas que tienen cierta relevancia desde el punto de vista de políticas o del debate público de interés nacional. Para aplicar el método se va a la fuente original como primer paso para solicitarles que nos indicaran sus fuentes de información en las que se basaba la frase emitida por el candidato de manera tal de estar 100 % seguros sobre la base de la afirmación y luego verificar los datos entregados. Muchas veces se daba que había una mala lectura de los datos o los datos no decían nada de la frase verificado. Entonces acudíamos a expertos en el tema para consultarles sobre esto y además íbamos a cifras oficiales existentes en el tema para contrastar la afirmación. Luego de eso se presentaba un reporte ante un comité editorial de expertos que tomábamos la decisión de catalogarla en alguna de las categorías predefinidas”, especifica el abogado y Magíster en Ciencias Jurídicas.

“Lo que es chequeable son las afirmaciones de hecho y no opiniones, ya que éstas no son ni verdaderas ni falsas. Las afirmaciones, sin embargo, pueden ser contrastadas con evidencias. El método supone que tienes que pulir aquella frase que puede ser o no verificable y para eso hay criterios de selección. Se eligen aquellas que tienen cierta relevancia desde el punto de vista de políticas o del debate público de interés nacional. Para aplicar el método se va a la fuente original como primer paso para solicitarles que nos indicaran sus fuentes de información en las que se basaba la frase emitida por el candidato de manera tal de estar 100 % seguros sobre la base de la afirmación y luego verificar los datos entregados. Muchas veces se daba que había una mala lectura de los datos o los datos no decían nada de la frase verificado. Entonces acudíamos a expertos en el tema para consultarles sobre esto y además íbamos a cifras oficiales existentes en el tema para contrastar la afirmación. Luego de eso se presentaba un reporte ante un comité editorial de expertos que tomábamos la decisión de catalogarla en alguna de las categorías predefinidas”, especifica el abogado y Magíster en Ciencias Jurídicas.

La comprobación entonces, se hace con recursos humanos. Según informan en su página web, el equipo que trabaja en la verificación del discurso, privilegia las afirmaciones que abordan temas de interés público y cuya comprobación implica un aporte al debate. Los temas prioritarios son:

- Salud

- Educación

- Pensiones

- Consumidores

- Corrupción

- Inmigración

- Araucania

- Diversidad sexual

- Transportes

- Seguridad

- Empleo

- Crecimiento económico

- Desigualdad

- Modernización del Estado

- Familia

- Igualdad de género

Según nos explicó Mauricio Duce, muchas veces se daba que había una mala lectura de los datos o los datos no decían nada de la frase verificado. “Entonces acudíamos a expertos en el tema para consultarles sobre esto y además íbamos a cifras oficiales existentes en el tema para contrastar la afirmación. Luego de eso se presentaba un reporte ante un comité editorial de expertos que tomábamos la decisión de catalogarla en alguna de las categorías predefinida: verdadero; verdadero, pero; discutible, falso, disparate, etcétera.

Escala calificación Chilecheck.

Seguimos entonces con una base. La comprobación la hacen personas. Uno o varios periodistas pasan horas frente a sus computadores revisando portales ayudados de un algoritmo hasta que encuentran una señal de alarma, se activa el protocolo y comienza el rastreo de la información hasta dar con la fuente. Pueden pasar horas hasta que se publique el desmentido o la corrección. Mientras tanto la noticia falsa, por otra parte, se esparció rápidamente, se viralizó, como se conoce comúnmente a esa situación.

Las fake news, según los estudios de expertos en la materia, tienen un 70% más de probabilidades de ser replicadas que las noticias fidedignas.

Fake news que matan

El diario inglés The Guardian informa que más de 20 personas han perdido la vida en la India en el último año por culpa de noticias falsas esparcidas a través de WhatsApp. Los mensajes hablaban de la presencia de secuestradores y violadores de menores en algunas zonas concretas del país asiático. La reacción fue una suerte de psicosis colectiva que provocó el linchamiento popular de varios ‘sospechosos’. Sin embargo, eran inocentes.

La mentira corre con agilidad. En febrero comenzó a circular una “noticia” que narraba una confabulación entre la ONU y el gobierno de Michelle Bachelet. En el texto se consignaba que se firmó un acuerdo secreto que tenía por objetivo que Chile recibiera a 3 millones de inmigrantes haitianos. En el acuerdo supuestamente se establecía un pago para la presidenta de US$3.000 por cada inmigrante.

La cadena se comparte por Whatsapp. Algún portal publica la información, otro la replica, un tercero toma la información, la redacta de nuevo y la publica en su web sin cita alguna. El virus ya se incubó.

Pero a veces, las noticias falsas operan al revés. Así sucedió con los secuestros de niñas en Nigeria por parte de la organización extremista islámica Boko Haram. En abril de 2014, se informó del secuestro de 276 estudiantes de una escuela secundaria de la localidad nigeriana de Chibok.

Pero a veces, las noticias falsas operan al revés. Así sucedió con los secuestros de niñas en Nigeria por parte de la organización extremista islámica Boko Haram. En abril de 2014, se informó del secuestro de 276 estudiantes de una escuela secundaria de la localidad nigeriana de Chibok.

Inmediatamente después del secuestro, los funcionarios del gobierno calificaron el crimen como un engaño, confundiendo y retrasando cualquier esfuerzo para rescatar a las niñas. Pero una semana después, las autoridades admitieron que habían sido los militantes islamistas y que efectivamente las jóvenes se encontraban desaparecidas. La periodista Stephanie Busari reporteó a fondo al caso de las “Chibok girls” y señala esta tragedia como un ejemplo brutal del peligro mortal de las noticias falsas y lo que podemos hacer para detenerlas.

“Hay personas muy inteligentes que trabajan en Google y Facebook que están intentando usar la tecnología para detener el crecimiento de las noticias falsas, pero más allá de eso, todos tenemos un rol que representar. Somos nosotros los que compartimos el contenido, las historias en internet… Hoy, todos somos editores y tenemos responsabilidades”.

Las elecciones, los bots y las noticias falsas

Pero el problema con las noticias falsas ha tenido su mayor repercusión en el manejo de las campañas presidenciales de los últimos periodos en el mundo. En México, por ejemplo, durante el periodo previo a la elección de Lopez Obrador como Primer mandatario, las noticias falsas fueron un asunto cotidiano. Fotos, vídeos y declaraciones manipuladas se usaron como ariete para atacar a los contendientes por la presidencia de México, un hecho que se favorece de los lectores que no cuestionan la información.

El Instituto nacional electoral mexicano se preocupó especialmente de fiscalizar las campañas de radio y televisión, pero internet escapa de sus facultades. Lo que hicieron fue aliarse con Verificando.mx, un portal compuesto por especialistas de decenas de medios que se dedican a buscar y analizar diferentes noticias que se viralizan en internet para determinar si se trata de noticias reales o las problemáticas fake news.

El problema con las campañas lo producen las desviaciones en la opinión pública que se dan artificialmente gracias a las cuentas falsas de Twitter y los bots. Pero, ¿qué son los bots? Son softwares que sirven para comunicarse con el usuario, imitando un comportamiento humano (aunque a veces sea el de un humano de pocas palabras). Estos programas funcionan dentro de otras aplicaciones y dan información y ayuda al usuario. Algunos bots tienen una inteligencia artificial más sofisticada y tratan de imitar el lenguaje humano en toda su complejidad, llegando a mantener conversaciones.

¿ Y cómo se aplica eso a la política?

El analista británico Ben Nimmo, experto en conflictos bélicos y estrategias políticas explica cómo funcionan y sus potenciales consecuencias en una campaña política.

“Piénsenlo como arrear ovejas. Tienen un grupo de pastores, que son personas reales, usuarios reales que planifican una campaña en línea, se ponen de acuerdo en un hashtag, crean memes o coordinan el horario de lanzamiento de la campaña. Luego tenemos los perros pastores que también son usuarios reales que retweetearan, amplificarán y copiarán los memes. Posteriormente tenemos la “caja” que retwitea y copia todo lo que los pastores y perros han publicado y además copian y reenvían lo que ella misma envía. Así un grupo de quizás una docena de personas pueden crear entre 20 mil y 40 mil tweets por hora. Después pueden instalar un hashtag en las listas de tendencias y así se desvirtúa completamente la idea de “una persona, un voto”. Alguien que controla 10 mil bots, controla 100 mil voces y distorsiona el debate.”

Entonces, si los bots se reproducen con tanta rapidez y los mecanismos de verificación son lentos, los expertos informáticos han decidido que la mejor solución es automatizar el proceso de comprobación.

La primera semana de septiembre la Universidad de Michigan (EEUU) anunció la creación de un mecanismo capaz de detectar fake news con más fiabilidad que los humanos. El proyecto, en colaboración con la Universidad de Amsterdam, está basado en un sistema de procesamiento natural (NPL, en inglés) con el que busca expresiones y estructuras lingüísticas para juzgar la credibilidad del texto. “Usamos secuencias y categorías de palabras o signos de puntuación. Estas representaciones se incorporan al aprendizaje del algoritmo y éste decide cómo valorarlas para dilucidar si la noticia es falsa o verdadera”, explicó Rada Mihalcea, directora del proyecto en el Instituto de Ciencia de Datos de la Universidad a elmundo.es

La primera semana de septiembre la Universidad de Michigan (EEUU) anunció la creación de un mecanismo capaz de detectar fake news con más fiabilidad que los humanos. El proyecto, en colaboración con la Universidad de Amsterdam, está basado en un sistema de procesamiento natural (NPL, en inglés) con el que busca expresiones y estructuras lingüísticas para juzgar la credibilidad del texto. “Usamos secuencias y categorías de palabras o signos de puntuación. Estas representaciones se incorporan al aprendizaje del algoritmo y éste decide cómo valorarlas para dilucidar si la noticia es falsa o verdadera”, explicó Rada Mihalcea, directora del proyecto en el Instituto de Ciencia de Datos de la Universidad a elmundo.es

Para Pablo Viollier, experto en Políticas Públicas de la ONG Derechos Digitales, el uso de este algoritmo puede ser utilizado como forma de censura, pues finalmente quien lo programa decide cuáles son las potenciales informaciones peligrosas.

“Los algoritmos, suelen no solamente replicar, sino exacerbar ciertos sesgos de generalmente hombres blancos que los programan, entonces la verdad es que la capacidad de estos mecanismos para combatir el discurso de odio, para combatir la desinformación, es súper complejo y como son mecanismos automatizados, al final uno debe preguntarse cuántas veces el algoritmo se equivoca y baja información que es legítima. Es válido entonces preguntarse cuánto contenido legítimo se va a estar bajando automáticamente”

Sigue, entonces, vigente la pregunta de si podemos dejar que esta decisión descanse solo en un algoritmo. Porque quienes efectivamente esparcen las noticias no son los bots ni los portales. Somos las personas, y las motivaciones de esto no han sido aún investigadas por los expertos, pese a que el MIT (Massachusetts Institute of Technology) ya ha fijado algunos parámetros como un deseo de estatus o de adquirir más seguidores.

La conclusión final de los estudiosos es que no podremos determinar si lo que leemos forma parte de una campaña de desinformación del creador o gestor del algoritmo. Es mucho más deseable dejar al usuario determinar por sí mismo si lo que lee es falso, impreciso o no. De lo contrario puede caerse en un ámbito de censura o manipulación y eso es precisamente lo que se busca erradicar.

Cadenas de mensajes telefónicos, videos posteados en redes sociales, noticias alarmantes repartidas en diversos portales de internet que se transmiten a una velocidad vertiginosa por nuestros correos y aparatos móviles. La búsqueda de una herramienta que permita reducir el impacto de las noticias falsas se ha tomado las investigaciones universitarias y se ha convertido en una prioridad para la comunidad internacional.

Año X, 14 de octubre de 2018

MENÚ

Campañas para erradicar fake news: ¿es el remedio peor que la enfermedad?

Cadenas de mensajes telefónicos, videos posteados en redes sociales, noticias alarmantes repartidas en diversos portales de internet que se transmiten a una velocidad vertiginosa por nuestros correos y aparatos móviles. La búsqueda de una herramienta que permita reducir el impacto de las noticias falsas se ha tomado las investigaciones universitarias y se ha convertido en una prioridad para la comunidad internacional.

Claudia Carvajal G.

El Servicio Electoral ha anunciado una serie de medidas para enfrentar un nuevo proceso de elecciones en Chile. Dentro de las iniciativas se ha hecho mención a la implementación de modificaciones legales que se hagan cargo de las de los actuales escenarios de información y tecnología. La propuesta dice relación con la “evaluación de medidas contra las campañas de noticias falsas ( fake news ), las campañas negativas y otras que han ido permeando las campañas electorales” según informó Patricio Santamaría, director del organismo a fines de septiembre.

Este proyecto del Servel responde a la irrupción de las nuevas tecnologías y, particularmente, el uso de redes sociales por las que se propagan estas noticias falsas con una velocidad asombrosa y cómo esto tuvo una importante injerencia en los procesos eleccionarios de Estados Unidos, el referéndum por el Brexit en el Reino Unido y recientemente en la primera vuelta de las elecciones presidenciales de Brasil.

El concepto “fake news” apareció en Chile a la par con el de postverdad en 2016. Ambos neologismos tienen en común su procedencia: las elecciones en Estados Unidos en las que ese país decidió a Donald Trump como presidente, lo que sigue siendo hasta hoy motivo de análisis.

Durante la pasada elección presidencial chilena, se implementó la plataforma Chilecheck cuyo objetivo era la comprobación de las declaraciones de los candidatos. Mauricio Duce, director de Espacio Público y uno de los expertos que trabaja en la plataforma digital de verificación de discurso público, nos explica el método que ellos utilizaron para llevar adelante esta comprobación.

La comprobación entonces, se hace con recursos humanos. Según informan en su página web, el equipo que trabaja en la verificación del discurso, privilegia las afirmaciones que abordan temas de interés público y cuya comprobación implica un aporte al debate. Los temas prioritarios son:

Según nos explicó Mauricio Duce, muchas veces se daba que había una mala lectura de los datos o los datos no decían nada de la frase verificado. “Entonces acudíamos a expertos en el tema para consultarles sobre esto y además íbamos a cifras oficiales existentes en el tema para contrastar la afirmación. Luego de eso se presentaba un reporte ante un comité editorial de expertos que tomábamos la decisión de catalogarla en alguna de las categorías predefinida: verdadero; verdadero, pero; discutible, falso, disparate, etcétera.

Escala calificación Chilecheck.

Seguimos entonces con una base. La comprobación la hacen personas. Uno o varios periodistas pasan horas frente a sus computadores revisando portales ayudados de un algoritmo hasta que encuentran una señal de alarma, se activa el protocolo y comienza el rastreo de la información hasta dar con la fuente. Pueden pasar horas hasta que se publique el desmentido o la corrección. Mientras tanto la noticia falsa, por otra parte, se esparció rápidamente, se viralizó, como se conoce comúnmente a esa situación.

Las fake news, según los estudios de expertos en la materia, tienen un 70% más de probabilidades de ser replicadas que las noticias fidedignas.

Fake news que matan

El diario inglés The Guardian informa que más de 20 personas han perdido la vida en la India en el último año por culpa de noticias falsas esparcidas a través de WhatsApp. Los mensajes hablaban de la presencia de secuestradores y violadores de menores en algunas zonas concretas del país asiático. La reacción fue una suerte de psicosis colectiva que provocó el linchamiento popular de varios ‘sospechosos’. Sin embargo, eran inocentes.

La mentira corre con agilidad. En febrero comenzó a circular una “noticia” que narraba una confabulación entre la ONU y el gobierno de Michelle Bachelet. En el texto se consignaba que se firmó un acuerdo secreto que tenía por objetivo que Chile recibiera a 3 millones de inmigrantes haitianos. En el acuerdo supuestamente se establecía un pago para la presidenta de US$3.000 por cada inmigrante.

La cadena se comparte por Whatsapp. Algún portal publica la información, otro la replica, un tercero toma la información, la redacta de nuevo y la publica en su web sin cita alguna. El virus ya se incubó.

Inmediatamente después del secuestro, los funcionarios del gobierno calificaron el crimen como un engaño, confundiendo y retrasando cualquier esfuerzo para rescatar a las niñas. Pero una semana después, las autoridades admitieron que habían sido los militantes islamistas y que efectivamente las jóvenes se encontraban desaparecidas. La periodista Stephanie Busari reporteó a fondo al caso de las “Chibok girls” y señala esta tragedia como un ejemplo brutal del peligro mortal de las noticias falsas y lo que podemos hacer para detenerlas.

“Hay personas muy inteligentes que trabajan en Google y Facebook que están intentando usar la tecnología para detener el crecimiento de las noticias falsas, pero más allá de eso, todos tenemos un rol que representar. Somos nosotros los que compartimos el contenido, las historias en internet… Hoy, todos somos editores y tenemos responsabilidades”.

Las elecciones, los bots y las noticias falsas

Pero el problema con las noticias falsas ha tenido su mayor repercusión en el manejo de las campañas presidenciales de los últimos periodos en el mundo. En México, por ejemplo, durante el periodo previo a la elección de Lopez Obrador como Primer mandatario, las noticias falsas fueron un asunto cotidiano. Fotos, vídeos y declaraciones manipuladas se usaron como ariete para atacar a los contendientes por la presidencia de México, un hecho que se favorece de los lectores que no cuestionan la información.

El Instituto nacional electoral mexicano se preocupó especialmente de fiscalizar las campañas de radio y televisión, pero internet escapa de sus facultades. Lo que hicieron fue aliarse con Verificando.mx, un portal compuesto por especialistas de decenas de medios que se dedican a buscar y analizar diferentes noticias que se viralizan en internet para determinar si se trata de noticias reales o las problemáticas fake news.

El problema con las campañas lo producen las desviaciones en la opinión pública que se dan artificialmente gracias a las cuentas falsas de Twitter y los bots. Pero, ¿qué son los bots? Son softwares que sirven para comunicarse con el usuario, imitando un comportamiento humano (aunque a veces sea el de un humano de pocas palabras). Estos programas funcionan dentro de otras aplicaciones y dan información y ayuda al usuario. Algunos bots tienen una inteligencia artificial más sofisticada y tratan de imitar el lenguaje humano en toda su complejidad, llegando a mantener conversaciones.

¿ Y cómo se aplica eso a la política?

El analista británico Ben Nimmo, experto en conflictos bélicos y estrategias políticas explica cómo funcionan y sus potenciales consecuencias en una campaña política.

“Piénsenlo como arrear ovejas. Tienen un grupo de pastores, que son personas reales, usuarios reales que planifican una campaña en línea, se ponen de acuerdo en un hashtag, crean memes o coordinan el horario de lanzamiento de la campaña. Luego tenemos los perros pastores que también son usuarios reales que retweetearan, amplificarán y copiarán los memes. Posteriormente tenemos la “caja” que retwitea y copia todo lo que los pastores y perros han publicado y además copian y reenvían lo que ella misma envía. Así un grupo de quizás una docena de personas pueden crear entre 20 mil y 40 mil tweets por hora. Después pueden instalar un hashtag en las listas de tendencias y así se desvirtúa completamente la idea de “una persona, un voto”. Alguien que controla 10 mil bots, controla 100 mil voces y distorsiona el debate.”

Entonces, si los bots se reproducen con tanta rapidez y los mecanismos de verificación son lentos, los expertos informáticos han decidido que la mejor solución es automatizar el proceso de comprobación.

Para Pablo Viollier, experto en Políticas Públicas de la ONG Derechos Digitales, el uso de este algoritmo puede ser utilizado como forma de censura, pues finalmente quien lo programa decide cuáles son las potenciales informaciones peligrosas.

“Los algoritmos, suelen no solamente replicar, sino exacerbar ciertos sesgos de generalmente hombres blancos que los programan, entonces la verdad es que la capacidad de estos mecanismos para combatir el discurso de odio, para combatir la desinformación, es súper complejo y como son mecanismos automatizados, al final uno debe preguntarse cuántas veces el algoritmo se equivoca y baja información que es legítima. Es válido entonces preguntarse cuánto contenido legítimo se va a estar bajando automáticamente”

Sigue, entonces, vigente la pregunta de si podemos dejar que esta decisión descanse solo en un algoritmo. Porque quienes efectivamente esparcen las noticias no son los bots ni los portales. Somos las personas, y las motivaciones de esto no han sido aún investigadas por los expertos, pese a que el MIT (Massachusetts Institute of Technology) ya ha fijado algunos parámetros como un deseo de estatus o de adquirir más seguidores.

La conclusión final de los estudiosos es que no podremos determinar si lo que leemos forma parte de una campaña de desinformación del creador o gestor del algoritmo. Es mucho más deseable dejar al usuario determinar por sí mismo si lo que lee es falso, impreciso o no. De lo contrario puede caerse en un ámbito de censura o manipulación y eso es precisamente lo que se busca erradicar.

Fuente

Compartir esto: